OpenAI前聯合創始人、Thinking Machines首席科學家John Schulman在近期訪談中提出,若早期團隊充分意識到規模擴展的回報率,ChatGPT的誕生時間可能大幅提前。他以2018-2019年為時間節點分析,認為僅需數位頂尖研究人員投入一年左右,即可構建出接近GPT-3.5水平的系統。這一判斷基于當前工程優化經驗的逆向推導,例如通過更高效的微調策略與數據構造技術,可顯著提升模型有效算力利用率。

作為強化學習領域權威專家,Schulman的學術履歷印證了其技術洞察力。他在博士期間師從強化學習先驅Pieter Abbeel,主導開發的PPO算法至今仍是ChatGPT核心技術RLHF的基礎組件。2024年其職業軌跡出現轉折,在短暫加盟Anthropic后,轉而擔任Thinking Machines首席科學家,該機構由OpenAI前CTO Mira Murati創立,致力于探索新型研究范式。

回顧OpenAI發展初期,Schulman將其描述為"學術草臺班子":2016-2017年的團隊架構呈現顯著非正式特征,研究項目多由個人興趣驅動,研究產出常以論文或博客形式呈現。這種松散模式孕育出重要突破,例如Dota項目通過大規模強化學習實現復雜策略游戲突破,但更多嘗試淪為技術死胡同。典型案例包括早期通用強化學習環境Universe,該平臺因系統臃腫與泛化能力不足最終被放棄,卻為后續研究提供了關鍵經驗。

針對當前AI研究生態,Schulman指出新銳機構面臨結構性挑戰。相較于早期OpenAI的愿景自然涌現模式,現代公司往往陷入"追趕陷阱"——在達到技術前沿前難以開展探索性研究。這種環境可能導致探索文化的缺失,而培養該能力需要從組織創立初期持續投入。他特別強調工程能力的重要性,指出隨著模型規模擴大,研究人員需具備扎實軟件工程基礎,純理論探索的價值相對下降。

在技術路線方面,Schulman預測聯合訓練生成器與驗證器將成為核心方向。這種多智能體博弈框架通過自我強化循環提升系統能力,類似辯論模型的理論機制可能重新獲得重視。對于持續學習難題,他認為上下文學習在短期任務中具有不可替代性,而長期記憶仍需依賴參數更新。離線強化學習被視為潛在突破口,其技術路徑與當前語言模型訓練存在相似性。

關于通用人工智能(AGI)發展時間表,Schulman提出經驗性修正系數。基于工程領域普遍存在的進度低估現象,他認為實際達成時間可能比多數預測延長2-3倍。自動駕駛領域的延遲案例被作為重要佐證,盡管AI的自我加速效應可能改變這一規律,但人類理解瓶頸等未知因素仍構成重大不確定性。這種審慎態度與其早期經歷相關——在AlphaGo等項目影響下,OpenAI始終保持工程嚴謹性與研究前瞻性的平衡。

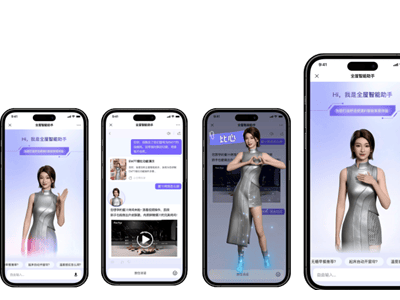

Thinking Machines最新發布的Tinker平臺體現了這種技術哲學。該微調API通過抽象底層復雜性,為研究者提供類似模型采樣服務的訓練體驗。當前版本主要面向專業用戶,未來計劃通過工具鏈擴展支持多模態訓練與大規模任務。公司計劃明年發布自主訓練模型,同時持續優化Tinker的功能層級,最終實現"業務問題到模型解決方案"的無縫轉化。