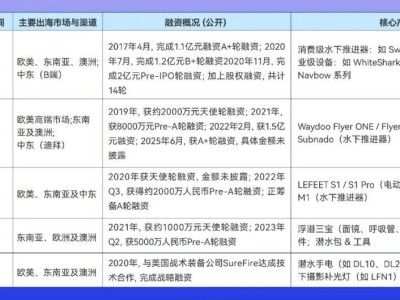

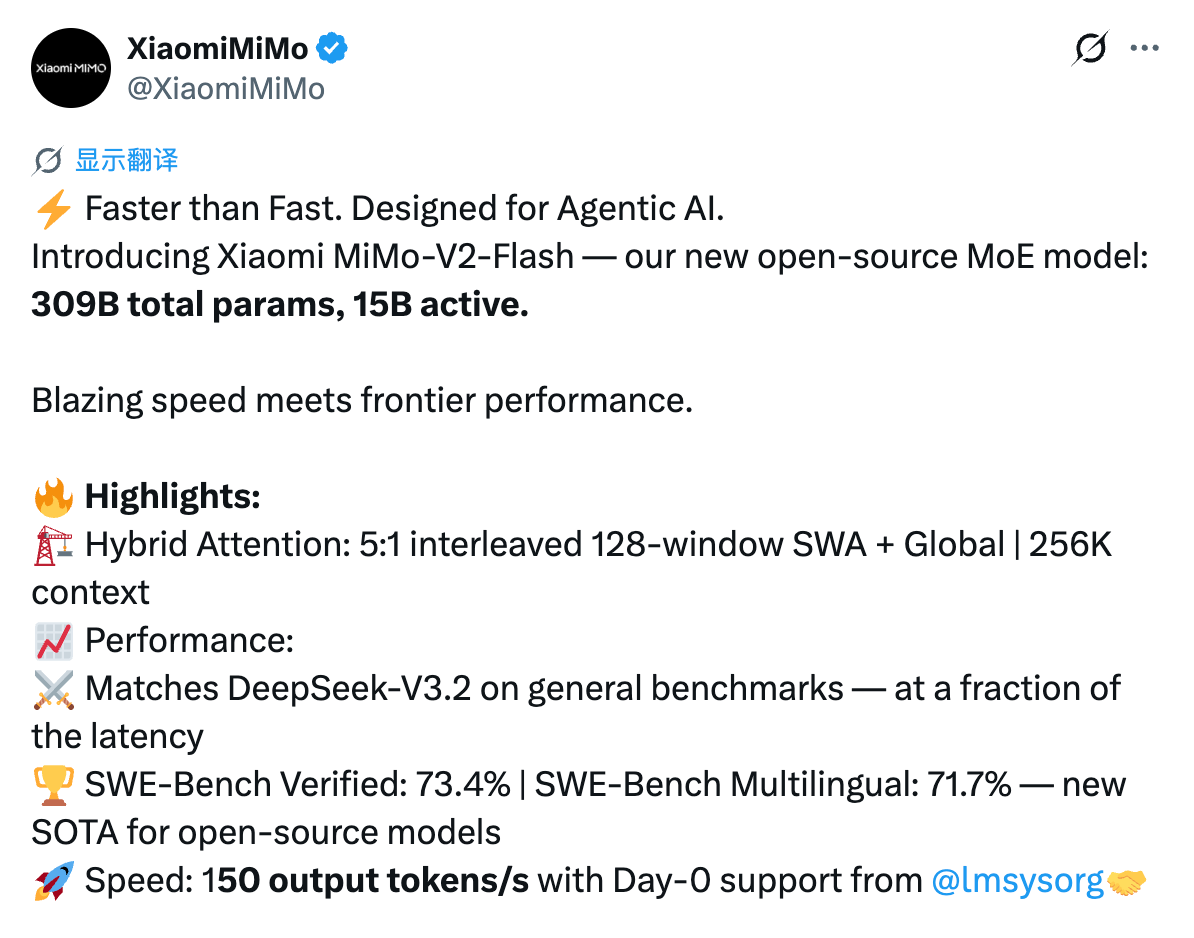

小米近日正式推出并開源全新大模型MiMo-V2-Flash,憑借3090億總參數與150億活躍參數的規模,在性能表現上與DeepSeek-V3.2、Kimi-K2等頭部開源模型形成有力競爭。該模型采用專家混合架構(MoE),通過架構層面的突破性創新,將推理速度提升至150 tokens/秒,同時將輸入成本壓縮至每百萬token僅0.1美元,輸出成本0.3美元,在性價比維度樹立新標桿。

在基準測試中,MiMo-V2-Flash展現多維優勢:AIME 2025數學競賽與GPQA-Diamond科學知識測試均位列開源模型前兩名;編程能力尤為突出,SWE-bench Verified測試得分73.4%,超越所有開源競品,直逼GPT-5-High水平。該測試要求AI修復真實軟件漏洞,73.4%的成功率意味著其已具備解決大部分實際編程問題的能力。多語言編程測試SWE-Bench Multilingual中,模型以71.7%的解決率進一步驗證跨語言開發實力。

智能體任務測試數據顯示,模型在τ2-Bench分類任務中,通信類得分95.3、零售類79.5、航空類66.0;BrowseComp搜索代理基準測試中,基礎得分45.4,啟用上下文管理后躍升至58.3。這些成績表明,MiMo-V2-Flash不僅能處理代碼生成等單一任務,更可理解復雜邏輯并執行多輪智能體交互。值得關注的是,其文本生成質量已接近頂級閉源模型,具備成為全能型日常助手的潛力。

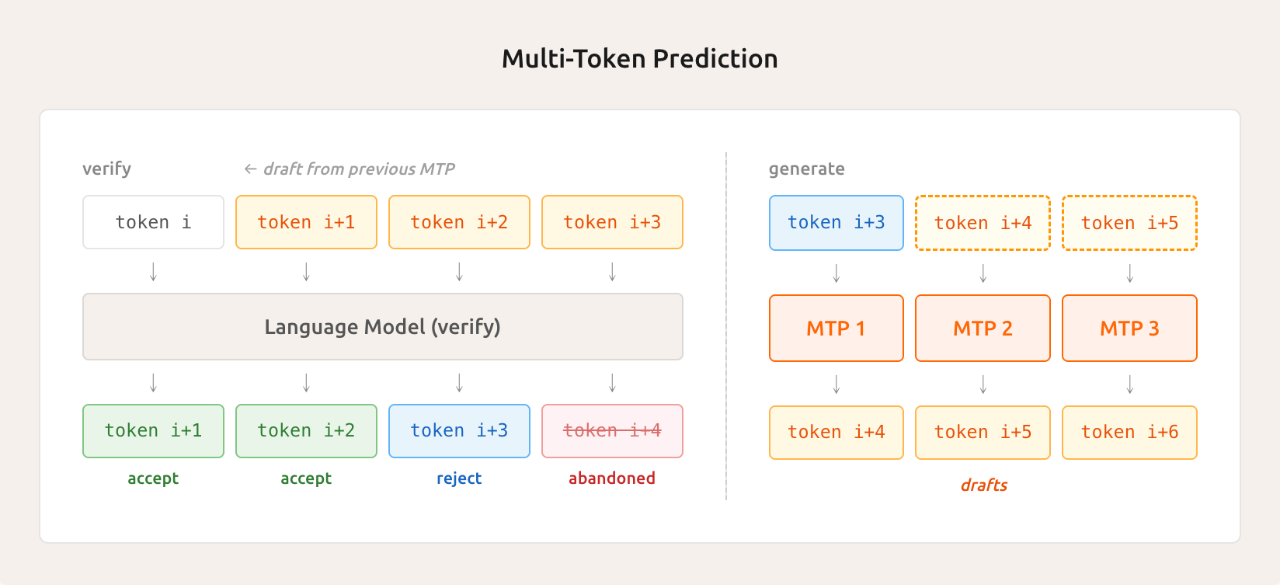

支撐模型性能突破的是兩項核心技術:混合滑動窗口注意力機制通過5層滑動窗口(每層128 token)與1層全局注意力的交替設計,使KV緩存存儲量減少近6倍,同時維持256k超長上下文窗口能力;輕量級多Token預測(MTP)模塊實現并行生成2.8-3.6個token,推理速度提升2-2.6倍,訓練階段采樣效率同步優化。研究團隊特別指出,128 token窗口大小經實驗驗證為"最佳甜點值",盲目擴大窗口反而導致性能下降。

訓練效率方面,模型采用FP8混合精度技術,在27萬億token數據上完成預訓練,原生支持32k序列長度。后訓練階段創新提出多教師在線策略蒸餾(MOPD),通過學生模型自主采樣、多專家教師實時反饋的機制,僅需傳統方法1/50的算力即可達到同等性能峰值。該框架支持動態接入新教師模型,形成"教學相長"的閉環進化系統。

針對開發者場景,MiMo-V2-Flash提供256k上下文窗口,可支持數百輪智能體交互與工具調用,與Claude Code、Cursor等主流開發環境無縫兼容。技術團隊基于真實GitHub issue構建超10萬個驗證任務,通過Kubernetes集群實現10000+并發Pod部署,環境部署成功率達70%。網頁開發任務中引入的多模態驗證器,通過視頻錄制替代靜態截圖驗證代碼執行結果,有效減少視覺幻覺問題。

目前,小米已將完整模型細節、推理代碼及基礎權重(含MiMo-V2-Flash-Base)通過MIT許可協議在Hugging Face平臺開源,并在LMSYS博客分享優化經驗。該模型現已在API Platform限時免費開放,開發者可直接調用體驗。