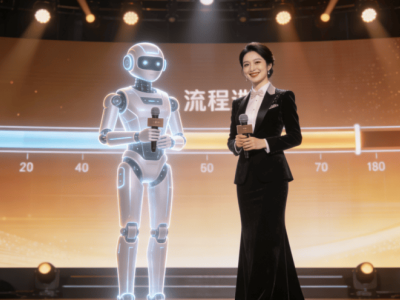

昆侖元AI在近期舉辦的世界計算大會上,正式推出了一款名為BaiZe-Omni-14b-a2b的全模態融合模型。這款模型基于昇騰(Ascend)平臺開發,集成了文本、音頻、圖像和視頻的強大理解與生成能力,標志著多模態技術邁向新的發展階段。其創新的技術架構包括模態解耦編碼、統一跨模態融合和雙分支功能設計,為多領域應用提供了堅實的技術基礎。

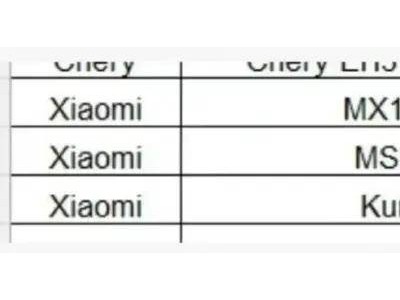

該模型的設計流程經過精心規劃,涵蓋輸入處理、模態適配、跨模態融合、核心功能實現和輸出解碼等多個環節。為了提升計算效率,研發團隊在MoE+TransformerX架構中引入了多線性注意力層和單層混合注意力聚合層。這些技術優化使得模型能夠高效處理大規模全模態任務,同時保持性能的穩定性。雙分支設計進一步增強了模型的理解與生成能力,使其能夠應對多達十類復雜任務,并生成高質量的多模態內容。

在訓練階段,昆侖元AI投入了海量高質量數據資源。訓練數據集包含超過3.57萬億token的文本數據、30萬小時以上的音頻數據、4億張圖像以及超過40萬小時的視頻數據。這種多樣化的數據組合不僅確保了單模態數據的純凈度,還實現了跨模態數據的高質量對齊。通過動態調整不同類型數據的配比,模型在各個訓練階段均能實現性能的漸進式提升,為最終的高水平表現奠定了基礎。

性能測試結果顯示,BaiZe-Omni-14b-a2b在多模態理解領域表現卓越。其文本理解準確率達到89.3%,在長序列處理任務中更是展現出明顯優勢。以32768token文本摘要任務為例,該模型的ROUGE-L得分達到0.521,超越了行業主流模型GPT-4的0.487。模型還支持多語言文本生成,并能夠同時處理圖像、音頻和視頻的生成任務,展現出全面的技術能力。

這款模型的應用前景十分廣闊。憑借其強大的全模態處理能力,BaiZe-Omni-14b-a2b將為智能客服、內容創作、多媒體分析等多個領域提供技術支持。其高效的處理能力和出色的生成質量,有望推動相關行業的技術革新,為人工智能的普及和應用開辟新的可能性。