在視頻理解領(lǐng)域,北大與UCSD聯(lián)合團(tuán)隊(duì)提出了一項(xiàng)創(chuàng)新框架——VideoOrion,其論文被國際計(jì)算機(jī)視覺頂會ICCV 2025以高分接收。該研究針對現(xiàn)有Video-LLM模型依賴下采樣或特征聚合導(dǎo)致細(xì)節(jié)丟失、語義糾纏的問題,提出將視頻中前景物體的時空動態(tài)顯式編碼為“對象令牌”(Object Tokens),并與背景上下文令牌(Context Tokens)并行輸入大語言模型(LLM),構(gòu)建出兼具高效性與可解釋性的視頻理解系統(tǒng)。

傳統(tǒng)方法通常將視頻幀分割為空間網(wǎng)格或聚合特征生成令牌,但這種處理方式容易混淆不同物體的語義信息。VideoOrion的創(chuàng)新之處在于,它將視頻中的對象及其跨幀演化視為獨(dú)立語義單元,通過“檢測-分割-跟蹤”三步流水線提取對象動態(tài)。具體而言,系統(tǒng)首先利用通用檢測模型GroundingDINO在關(guān)鍵幀生成候選框,再通過分割模型SAM細(xì)化對象掩碼,最后用跨幀跟蹤器XMem生成隨時間變化的掩碼序列。這些掩碼經(jīng)過特征池化與投影后,形成語義解耦的Object Tokens,每個令牌對應(yīng)一個獨(dú)立物體的動態(tài)信息。

在雙分支編碼架構(gòu)中,Context Tokens分支采用CLIP或SigLIP模型對采樣幀進(jìn)行編碼,生成承載背景與場景信息的上下文令牌;Object Tokens分支則通過上述流水線提取對象級動態(tài)。兩類令牌被并行輸入LLM進(jìn)行融合推理,使模型既能捕捉全局場景信息,又能聚焦關(guān)鍵對象的細(xì)節(jié)變化。例如,在描述“紅色三輪滑板車”時,模型不僅能識別其顏色與類型,還能解析“拖地組件”等細(xì)節(jié);在分析動作場景時,可精確分解“黑色泳裝跳板后空翻”中的動作要素。

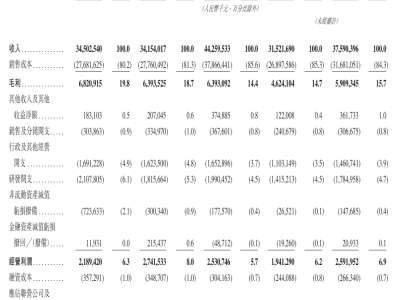

實(shí)驗(yàn)表明,VideoOrion在MVBench、EgoSchema、Perception-Test等五大基準(zhǔn)測試中全面超越同規(guī)模模型。以7B參數(shù)版本為例,其在MVBench上的準(zhǔn)確率達(dá)63.5%,較VideoLLaMA2提升10.1%;在EgoSchema上得分65.1,漲幅達(dá)14.6%。特別在視頻指代任務(wù)中,該框架展現(xiàn)出獨(dú)特優(yōu)勢:通過在提示模板中填入目標(biāo)對象對應(yīng)的令牌,即可直接回答“這個物體在做什么”等問題。在VideoRef45K數(shù)據(jù)集上,經(jīng)少量微調(diào)后,其BLEU@4、METEOR等指標(biāo)均顯著優(yōu)于Artemis、Merlin等現(xiàn)有方法。

研究團(tuán)隊(duì)通過消融實(shí)驗(yàn)驗(yàn)證了設(shè)計(jì)合理性:移除對象分支會導(dǎo)致性能全面下降;預(yù)訓(xùn)練對象分支可提升模型表現(xiàn),說明對象令牌需先學(xué)習(xí)基礎(chǔ)語義再與文本對齊;令牌數(shù)量控制在64個時模型最穩(wěn)定,過多會分散注意力。流水線組件替換實(shí)驗(yàn)顯示,RAM++自適應(yīng)分段策略與XMem跟蹤器的組合效果最佳,較均勻分段或SAM2跟蹤均有明顯優(yōu)勢。

盡管VideoOrion在性能上取得突破,但研究也指出其局限性:引入專用視覺模型帶來約38.5%的時延開銷,低質(zhì)量視頻可能導(dǎo)致掩碼不準(zhǔn)確;當(dāng)前仍依賴視頻分支提供上下文,對象-場景融合機(jī)制需進(jìn)一步優(yōu)化。該框架通過結(jié)構(gòu)化重寫視頻語義,為視頻問答、機(jī)器人感知等任務(wù)提供了新范式,其雙視角編碼思路或推動多模態(tài)領(lǐng)域向更精細(xì)化的方向發(fā)展。